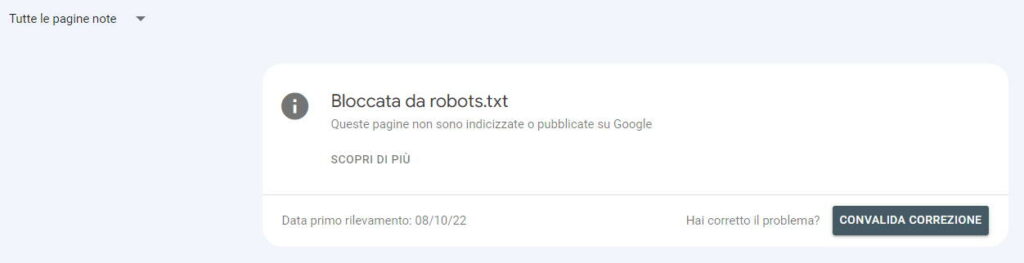

Se se arrivato fin qui avrai sicuramente ricevuto l’avviso all’interno di Google Search Console di “Bloccata da robots.txt“, ovvero Google ha rilevato che ci sono delle pagine all’interno del sito che sono bloccate dal file robots.txt.

Partiamo subito con il dire che non c’è niente di male ad avere delle pagine bloccate dal robots.txt, l’importante è non avere contenuti importanti non scansionabili dai motori di ricerca.

Come controllare quali pagine sono bloccate?

Per prima cosa dovrai recarti all’interno del file incriminato, collegandoti all’indirizzo https://tuosito.it/robots.txt

Da lì potrai controllare quali sono le sezioni/contenuti accessibili ai motori di ricerca o meno.

Per testare le pagine puoi utilizzare questa piattaforma: https://technicalseo.com/tools/robots-txt/

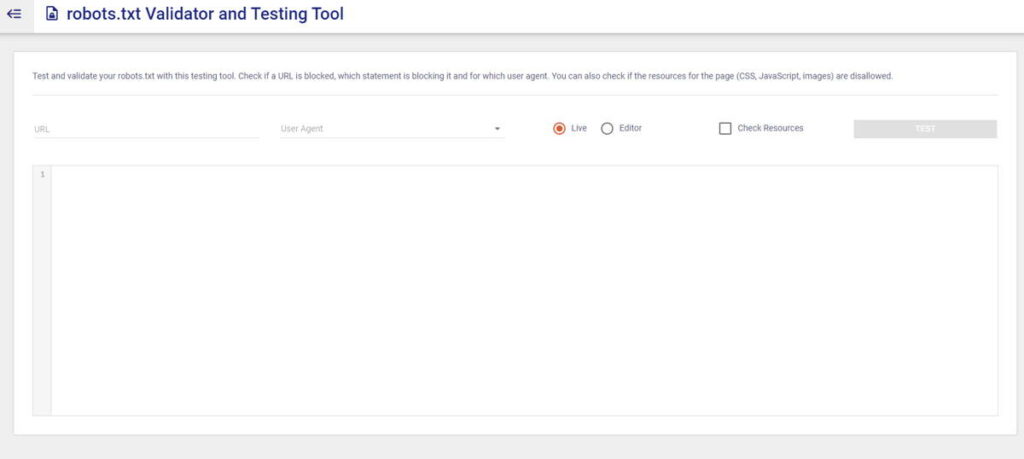

Oppure puoi utilizzare direttamente lo strumento messo a disposizione da Search Console.

Una volta verificato che sia tutto ok, che non ci siano pagine importanti bloccate dal file, puoi tranquillamente ignorare l’avviso all’interno della GSC, altrimenti dovrai andare a modificare il file.

Considera che Google farà riferimento solo ed esclusivamente al robots.txt nella root, quindi impegnati ad ottimizzare e migliorare quello.

Normalmente lo trovi nella root del tuo sito web, accedendo da FTP o da Gestione File dal tuo pannello di controllo.

Per tutte le regole e la giusta sintassi del file robots.txt puoi leggere il mio articolo dedicato o la guida ufficiale di Google.

Ripeto, di per sé non è un errore grave, ma c’è sempre da approfondire questo avviso, molte volte potresti scoprire delle “spiacevoli” sorprese.

Controlla URL per URL.

Buona SEO,

Michele.

Lascia un commento